La AudiologIA (II): Datos y Fenotipado profundo

Análisis de Datos y Fenotipado Profundo

El segundo mensaje provocador y motor de la transformación es:

“La inteligencia artificial permitirá dar más sentido a los datos”.

La IA transforma la forma en que entendemos y clasificamos la pérdida auditiva.

1. Adquisición Masiva de Datos (Datalogging)

Los audífonos actuales recogen una vasta cantidad de datos longitudinales sobre el uso, el ambiente sonoro y las interacciones del usuario. La IA permite minar estos datos, reconocer patrones y agrupar la información (Clustering), convirtiendo la adquisición masiva de datos en conocimiento útil.

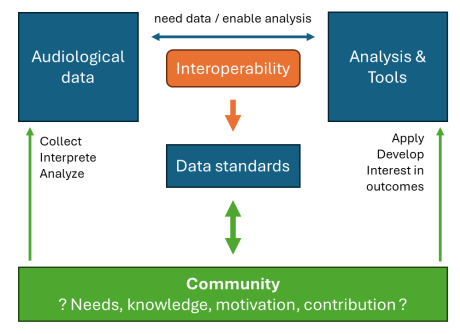

2. Estandarización de Datos y Bases de Datos Clínicas

Para que el minado de datos sea valioso, es crucial la estandarización de los datos en audiología, permitiendo la integración de inputs de múltiples fuentes (hospitales, universidades, territorios). El objetivo es ir más allá de la audiometría y comprender déficits más complejos como la hipoacusia oculta o el tinnitus, así como comorbilidades (e.g., demencia, procesos metabólicos).

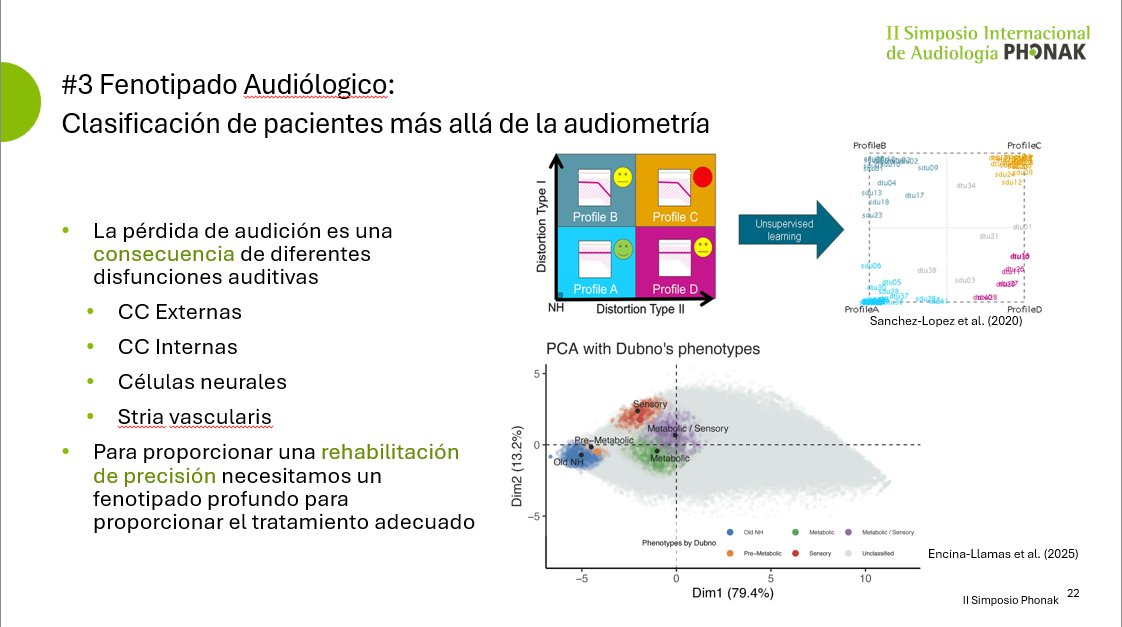

3. Fenotipado Audiológico para la Rehabilitación de Precisión

La pérdida de audición es una consecuencia de diversas disfunciones auditivas. Para ofrecer una rehabilitación verdaderamente precisa y el tratamiento adecuado, es necesario un fenotipado profundo que clasifique a los pacientes más allá de su audiograma. Esto lo hicimos en mi doctorado usando una "perfilacion auditiva basada en datos" (Sanchez-Lopez et al., 2020), la cual ha inspirado el trabajo que han hecho en otros laboratorios en una dirección similar.

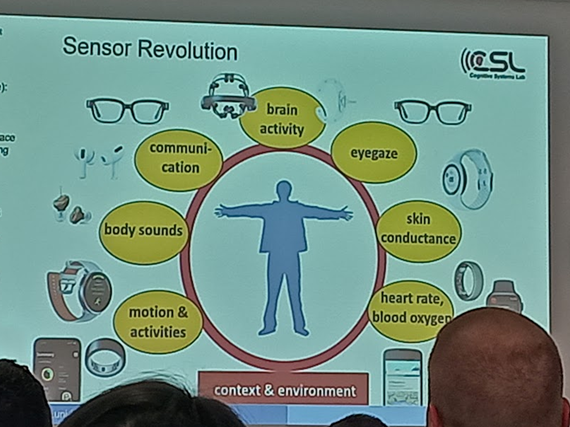

4. Wearables, Comportamiento y Biometría

Multitud de dispositivos pueden monitorizar aspectos del comportamiento y la salud general: localización, frecuencia cardíaca, patrones de sueño y ejercicio. Esta monitorización continua y no invasiva tiene el objetivo de inferencia, proporcionando un conocimiento sin precedentes del paciente en su ecología auditiva real.

5. Fenotipado Digital y Gemelos Digitales

La combinación de todos estos datos permite el concepto de gemelo digital del paciente. Esto nos lleva a la intervención de precisión, que sustituirá a la intervención convencional al adaptar el tratamiento no solo a la pérdida auditiva, sino al estilo de vida, las preferencias y el perfil fisiológico del individuo.

Apuntate al webinar: ¿Cómo la Investigación y la Tecnología están Tranformando la Audiología? que impartiré el 16 de Diciembre 2026

Tres Predicciones Clave para el Futuro (II)

Predicción #2: Minimización de la Restricción de Actividades: Los datos proporcionarán un conocimiento mucho más profundo de la audiología y el comportamiento real del paciente. Este Big Data del comportamiento será clave para minimizar la restricción de actividades asociadas a la pérdida auditiva.

Referencias

- Callejón-Leblic, M. A., Blanco-Trejo, S., Villarreal-Garza, B., Picazo-Reina, A. M., Tena-García, B., Lara-Delgado, A., … Sánchez-Gómez, S. (2024). Una base de datos multimodal para la recopilación de datos de investigación audiológicos interdisciplinares. Auditio, 8, e109. https://doi.org/10.51445/sja.auditio.vol8.2024.109

- Cherri, D., Eddins, D. A., & Ozmeral, E. J. (2024). A Step Toward Precision Audiology: Individual Differences and Characteristic Profiles From Auditory Perceptual and Cognitive Abilities. Trends in Hearing, 28, 23312165241263485. https://doi.org/10.1177/23312165241263485

- Christensen et al. (2019). Fully Synthetic Longitudinal Real-World Data From Hearing Aid Wearers for Public Health Policy Modeling. Frontiers in Neuroscience, 13.https://doi.org/10.3389/fnins.2019.00850.

- Pasta et al. (2021). Clustering Users Based on Hearing Aid Use: An Exploratory Analysis of Real-World Data. Frontiers in Digital Health, 3.https://doi.org/10.3389/fdgth.2021.725130.

- Saak, S., Huelsmeier, D., Kollmeier, B., & Buhl, M. (2022). A flexible data-driven audiological patient stratification method for deriving auditory profiles. Frontiers in Neurology, 13, 959582. https://doi.org/10.3389/fneur.2022.959582

- Sanchez Lopez, R., Fereczkowski, M., Neher, T., Santurette, S., & Dau, T. (2020). Robust Data-Driven Auditory Profiling Towards Precision Audiology. Trends in Hearing, 24, 2331216520973539. https://doi.org/10.1177/2331216520973539

- Spriggs, R. V., Bateman, P., Sanchez-Lopez, R., Thornton, S. K., Phillips, O. R., Hoare, D. J., & Wiggins, I. M. (2025). Deep phenotyping to understand hearing and hearing disorders: Protocol for a feasibility study. Plos One, 20(3), e0320418. https://doi.org/10.1371/journal.pone.0320418

- Su, Q., Peretokin, V., Basdekis, I., Kouris, I., Maggesi, J., Sicuranza, M., Acebes, A., Bucur, A., Mukkala, V. J. R., Pozdniakov, K., Kloukinas, C., Koutsouris, D. D., Iliadou, E., Leontsinis, I., Gallo, L., De Pietro, G., & Spanoudakis, G. (2023). The SMART BEAR Project: An Overview of Its Infrastructure. Information and Communication Technologies for Ageing Well and E-Health, 408–425. https://doi.org/10.1007/978-3-031-37496-8_21

- Vercammen, Charlotte & Heinrich, Antje & Lesimple, Christophe & Paglialonga, Alessia & Wasmann, Jan-Willem & Buhl, Mareike. (2025). Data Standards in Audiology: A Mixed-Methods Exploration of Community Perspectives and Implementation Considerations. 10.48550/arXiv.2505.04728.

Member discussion